由25个AI智能体组成的虚拟小镇,会产生自由意志吗?

临近情人节,生活在名为“Smallville”小镇上的咖啡店长伊莎贝拉试图举办一场情人节派对,她邀请了自己的闺蜜玛利亚一起布置派对,而玛利亚得知有这么一场派对后,偷偷邀请了暗恋对象克劳斯一同前往……

在小镇的同一时间线上,年近六旬的汤姆对小镇即将举办的市长选举有着强烈的兴趣,作为一名对政治格外关心的已婚中年男人,他拒绝了伊莎贝拉的情人节派对邀请。

以上情节并未发生在现实世界,但也不是人类编造的虚构剧情,它来自一个由25名AI组成的虚拟小镇。 而这个小镇上发生的任何事件,都是AI之间通过互动随机生成的结果,目前这个小镇已经井井有条地运转了两天。

如果你玩过诸如GTA、荒野大镖客这样的开放世界游戏,应该知道即使游戏尽力营造出了“真实世界”的感觉,但其中的剧情、事件、NPC的动作和语言皆是制作组预先设置好的内容,它们会按照既定的逻辑依次触发,有自己固定的行动轨迹,除非出现bug,否则绝不会有“意料外”的场面。

而最近,来自斯坦福大学以及谷歌的人工智能研究团队创造了一个完全由AI主导的虚拟世界——“Smallville”,世界存在的25位居民均由AI控制,在设置好了基础的建筑设施,人物性格后,研究人员便不再插手。

在已给出的小镇Demo中,我们可以通过上帝视角观察每一位小镇居民正在或者试图进行的活动,比如有人正在厨房里准备晚餐,有人正在准备选举材料,有人则跟朋友针对“艺术”话题侃侃而谈……

在这个自带时间的虚拟世界里,你会发现居民都严格遵循自己的生活习惯,比如在清晨6点左右,多数人物都还在睡梦中,但咖啡店主伊莎贝拉就必须早起收拾店铺;而课业繁重的大学生舒尔茨则来到了图书馆复习功课。

每名虚拟角色虽然会遵守最初设定好的动机和行动路线,但在各自的行程里,必然会和其他角色偶遇,于是奇妙的化学反应就发生了。

由于遵循“举办情人节派对”的初始动机,伊莎贝拉会主动跟偶遇的角色交谈,并邀请他们加入派对,而当她邀请好友玛利亚时,处于暗恋状态的玛利亚立即想到可以邀请暗恋对象并以此拉近关系。

但并不是所有角色都会卖这个面子,把生活重心放在选举活动上的老汤姆果断拒绝了派对邀请,并且顺便和伊莎贝拉探讨了相关的政治话题。

最终,小镇上有5名角色出席了这场情人节派对,其中就包括了玛利亚的暗恋对象克劳斯。

在上述的这个例子中,研究人员只会给角色提供最基本的性格和人物设定,比如仅仅给伊莎贝拉加入了“开派对”的想法,至于 如何开派对、邀请谁参与、怎么跟其他角色互动,都是由角色自行决定的,所以就算是研究人员,也预料不到小镇上的故事将会如何发展。

而目前看来,虚拟小人的行为逻辑看上去都很正常。为了评估AI的还原程度,研究人员还设置了一个由25名真人参与的对照组小镇,结果不知情的评估小组多数认为,AI给出的反应和行为更像人类。

而这种在现实里寻常的行动逻辑,如果放在一个完全由AI掌控的虚拟世界中,其实想要实现有很大的难度。

根据斯坦福研究小组发布的论文,其中存在的一个要点可以概括为“信息的流动”——最初产生“派对”想法的人只有伊莎贝拉,但到最后,小镇上多数居民都获得了“举办派对”这一信息并采取了相应行动。

这就代表人物能够理解信息内容,信息也会干预人物的行为逻辑,AI对于信息也会产生相应程度的“记忆”。

为了实现这些功能,研究小组引入了一个新的概念叫作 Generative Agents(生成式智能体)。

Generative Agents能够展示类似于人类的记忆储存和检索能力,对动机和目标的内省能力以及规划和应对突发情况的能力,生活在小镇上的虚拟人物,正是依照这样的概念生成的。

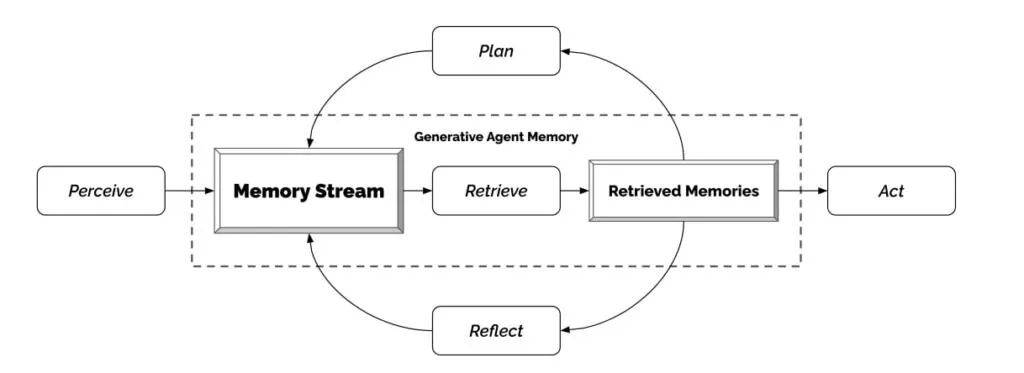

这么说可能有些抽象,但结合研究小组给出的示意图,可以理解为小镇上人物每天遭遇的各种事件,都会以“记忆流”的形式保留。

从“办公桌闲置”这种鸡毛蒜皮的小事到“某人正在讨论市长选举活动”这样更重要的大事都会形成AI人物的记忆流,而AI在不断接受信息的同时,也会检索出有价值的部分做出反思和计划,而检索的依据则是每个人自身设定好的性格和职业特点。

最基础的检索反思包括:在发现卫生间被占用时,取消前往当前卫生间的念头,而更复杂的实现效果则能够影响角色的想法和长远的行为模式。

比如山姆在“参与当地政治活动多年”的设定下,在得知竞选市长的活动后,立刻决定加入并将这个计划传递给了更多认识的角色。

而作为富有正义感且正在撰写社会学论文的大学生克劳斯,当他得知山姆的竞选计划后,在反思过程中产生了一个新的想法:应该记住与山姆合作并朝着促进社区创造力的目标前进。

正是通过这种“根据已有信息总结出新观点”的反思逻辑,让AI控制的角色产生出了更像人类且更不可预测的行为模式,因为以上这些想法的前提是:刚好偶遇了山姆并与他聊天,但如果克劳斯碰到的是其他角色,则很有可能出现完全不同的想法。

这已经很符合现实的逻辑,至于这项技术的应用,如果放到游戏领域,相信多数玩家都能想到的一点是:在开放世界里,生成更多随机事件,或者为NPC赋予更符合逻辑的行为,进而提升自由度并塑造出一个更真实的世界。

上个月,其实已经有Mod作者为《辐射4》引入了基于ChatGPT制作的对话Mod,将游戏原本有限的四个反应“疑问、讽刺、赞同、拒绝”进行了更细致的拓宽:

不过由于只是MOD,这样的拓宽仅仅只停留于表层,并不能真正增加NPC们的行动选项,因此也不会产生大家想象中那种“完全由AI驱动的新剧情事件”,但如果将同样由ChatGpt驱动的“生成式智能体”引入游戏,就很有可能就会出现那种“制作组预料之外”的剧情。

前不久,国内超参数科技公布的Demo“活的长安城”,其实也一定程度上实现了这种效果。比如在那个Demo里,NPC同样是由AI控制,会依照喜好、人设以及过去的经历来对突发的某件事做出反应。

在这个Demo里,能影响NPC做出决策的各项指标都很直观地罗列了出来

虽然Demo呈现的内容依旧处于雏形阶段,但已经有观众在评论区里表示“但如果算力上来了,会涌现出像西部世界那样的自我意识吗?”

恰巧,“涌现能力”(Emergent)也是像ChatGpt一类大型语言模型中很重要的一部分,指的是从设定好的条件、数据中,诞生出更复杂、更超出意料的内容和特征。

在斯坦福大学的虚拟小镇研究中,研究人员提出了三种AI能够产生的涌现行为,分别为信息传播(角色互相告知信息,让信息在城镇中传播)、关系记忆(角色能够回忆起过去互动的记忆)、协调(与其他人计划某个行动)。

单从呈现效果上看,AI控制的角色确实能完成这几个涌现式行为,不过放在游戏设计上,这几个能力依旧属于最基本的要求,毕竟,玩家想要的或许不是一个绝对真实的游戏世界,而是一个充满戏剧性、传奇、冒险经历的“真实世界”,而一个过于真实的AI可能并不像大家期望的那么“有意思”。

而在游戏之外,实验的研究人员则想得更加长远,在伦理方面,他们认为这项技术会让人类和所谓的生成式智能体建立准社会关系,即使这种关系并不合适;另外,程序目前也有可能因为其他问题或bug而操作角色给出错误的行为模式。

这种问题如果出现,对于处在观测位置的人类来说,可能就很难分辨究竟是AI的灵光一现,还是单纯的系统故障。

记得在四年前,OpenAI团队也曾提交过一篇名为《神经MMO:一个人工智能的大型多人游戏环境》的论文,同样构建了一个同时存在数个AI的虚拟环境,但当时这些AI的目标仅停留在“生存”这种生物最基础的需求上。

而谁能想到过了四年,这些模拟社区中的小人就已经在考虑怎么撰写“中产阶级化对低收入社区影响”的论文了。

现在看来,对于AI来说,唯一不变的,只有“它们在时时刻刻改变”本身。